В процессе улучшений интерфейса цифрового продукта всегда возникает вопрос: помогает ли это пользователю решать его задачу? И ответить на него не так-то просто. Расплывчатые формулировки вроде «так удобнее» не показывают, что именно и насколько стало лучше.

Сопоставительный анализ пользовательского опыта, он же UX-бенчмаркинг, решает эту проблему. Он показывает, насколько легко и успешно пользователи проходят ключевые сценарии, давая объективную основу для оценки изменений в интерфейсе.

Что такое UX-бенчмаркинг и какую задачу он решает

UX-бенчмаркинг — это способ оценить качество взаимодействия с продуктом в ключевых пользовательских сценариях и отслеживать изменения со временем. Фокус смещается с отдельных экранов или элементов интерфейса на то, как пользователь решает задачу от начала до результата.

Задача подхода в том, чтобы дать единую точку отсчета. По ней команда понимает, как именно сейчас проходят базовые сценарии, где возникают ошибки, задержки или лишние действия. После изменений замер повторяют в тех же условиях. Это дает возможность сравнивать результаты напрямую и видеть динамику, а не опираться на субъективные ощущения или разрозненные сигналы.

В работе над мобильными и веб-сервисами UX-бенчмаркинг помогает сохранять управляемость. Он задает общий ориентир эффективности интерфейса, упрощает расстановку приоритетов и формирует единый фундамент для выбора интерфейсных решений.

Когда эффект UX-бенчмаркинга максимален

Такой анализ пользовательского опыта особенно полезен в ситуациях, где цифровой продукт регулярно меняется и команде нужно точно понимать эффект этих изменений. Прежде всего, это проекты с итеративным развитием. Когда улучшения вносят постепенно, без контрольной точки можно потерять ощущение прогресса. Бенчмаркинг здесь используют как регулярную сверку планов, которая помогает видеть динамику по ключевым сценариям, а не оценивать изменения по отдельным экранам.

Отдельный случай — редизайн интерфейса. Первый замер позволяет зафиксировать текущее состояние сценариев, а повторный показывает, что именно изменилось в них после обновления.

Подход также хорошо работает в системах с растущей сложностью. По мере появления новых функций и ветвлений сценариев он помогает команде удерживать фокус на том, насколько стабильно и предсказуемо пользователь решает свои задачи. В этом контексте бенчмаркинг выступает не разовым исследованием, а инструментом контроля состояния пользовательского опыта.

Почему UX-бенчмаркинг и A/B-тестирование не заменяют друг друга

UX-бенчмаркинг и A/B-тестирование часто упоминают рядом, но это инструменты разного профиля. Путаница между подходами приводит к завышенным ожиданиям и неверной интерпретации результатов. Важно сразу развести их по задачам:

-

A/B-тестирование используют, когда нужно сравнить несколько вариантов в живом трафике и понять, какой из них работает лучше в текущих условиях. Оно хорошо показывает относительную разницу между версиями, но не дает ответа, насколько сам сценарий удобен и устойчив. Поэтому выиграть может вариант, который лучше альтернативы, но все еще плохо работает для пользователя.

-

UX-бенчмаркинг фиксирует состояние пользовательских сценариев и позволяет оценить, изменилось ли качество взаимодействия после доработок. Здесь важна не конкуренция вариантов, а сопоставимость замеров во времени. Такой подход помогает понять, стало ли пользователю проще решать задачу в продукте.

Такое разделение ролей между подходами позволяет избежать ситуации, когда локальная победа в тесте скрывает системные проблемы пользовательского опыта.

Из каких элементов состоит корректный UX-бенчмаркинг

Чтобы получать сопоставимые результаты, команда должна выстраивать анализ как устойчивую систему, а не как разовый замер. Для этого нужно заранее определить ключевые элементы, на которые будет опираться каждая новая итерация анализа:

-

Контрольные сценарии. Их выбирают по ценности для продукта. Это ограниченный набор задач, через которые пользователь получает ключевой результат. Чем точнее определены сценарии, тем меньше шума в выводах и очевиднее точки, требующие изменений.

-

Метрики. Они должны отвечать на конкретные вопросы и быть одинаковыми от замера к замеру. Команда исследования должна заранее договориться, что именно измеряется и зачем. Смешение разных показателей без понятной логики быстро лишает результаты практической ценности.

-

Условия проведения. Состав участников, тип устройства, инструкции, среда выполнения задач должны оставаться неизменными. Даже небольшие отклонения делают сравнение формальным и затрудняют интерпретацию динамики.

-

Регулярность замеров. UX-бенчмаркинг должен работать как повторяющийся процесс. Замеры привязывают к значимым изменениям продукта и используют как регулярную точку контроля.

Замерять пользовательский опыт удобно на специализированных платформах задачного тестирования. Это, например, сервисы Maze, UXtweak, Lookback, Userlytics или Lyssna, которые автоматически фиксируют завершение задач, успешность и время.

Task Completion и Task Success Rate — ключевые метрики UX-анализа

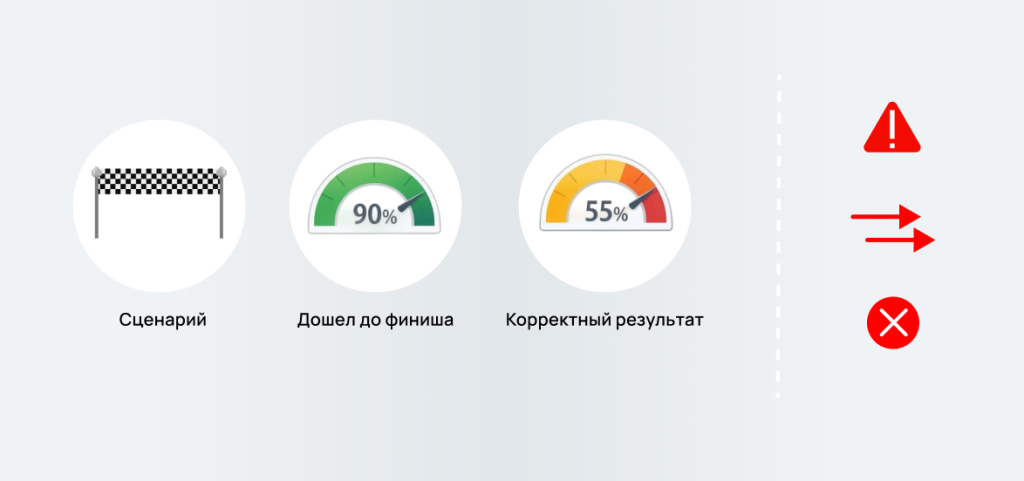

При оценке качества интерфейсов основное значение придают метрикам выполнения пользовательских задач. Они помогают понять, может ли пользователь пройти заданный сценарий и с каким результатом он это делает. Для оценки этого чаще всего используют метрики Task Completion и Task Success Rate. Они довольно похожи, однако отвечают на разные вопросы и показывают разные стороны взаимодействия с продуктом. Поэтому важно правильно понимать и применять их:

-

Task Completion фиксирует сам факт завершения задачи. Метрика фиксирует, дошел ли пользователь до конца сценария и получил ли результат в принципе. При этом не учитывается, как именно он к нему пришел. Пользователь мог допускать ошибки, возвращаться на предыдущие шаги, действовать неочевидным способом или тратить больше времени, чем ожидалось. Task Completion дает ответ, сценарий выполнимый или нет. Получать такие данные можно как с помощью сервисов задачного тестирования, так и непосредственно в продукте, анализируя воронку событий.

-

Task Success Rate оценивает успешность выполнения задачи. Для этого задают критерии корректного результата и оценивают, какая доля пользователей выполнила задачу именно в этом виде. В фокусе не само завершение, а его качество: пользователь получил нужный итог, без критических ошибок и в ожидаемом состоянии сценария. Task Success Rate удобно измерять там, где можно заранее задать критерии успешного результата для каждой задачи. Так работают, например, системы UXtweak и Userlytics.

Разница между этими метриками становится заметной при анализе результатов. Например, сценарий может иметь высокий Task Completion и при этом низкий Task Success Rate. Пользователи доходят до конца, но делают это с ошибками, лишними действиями или неправильным результатом. Формально задача решается, но фактически интерфейс создает нагрузку и повышает риск.

Поэтому в UX-бенчмаркинге эти метрики рассматривают отдельно. Task Completion помогает выявить сценарии, которые ломаются полностью. Task Success Rate показывает, насколько легко пользователь достигает результата. Вместе они дают более точное понимание того, как люди взаимодействуют с продуктом и где скрыты проблемы, которые не видны при поверхностной оценке.

Как задавать критерии успешного выполнения задачи

Метрика Task Success Rate работает только тогда, когда критерии успеха заданы заранее и однозначно. Без этого одна и та же задача может считаться выполненной по разным основаниям, а результаты теряют сопоставимость.

Пример итога: пользователь завершил действие без ошибок, ввел данные в нужном формате и оказался в ожидаемом состоянии системы. Чем точнее описан результат, тем стабильнее замеры.

Отдельного внимания требуют ошибки. Их следует разделять по значимости. Критические делают результат неприемлемым и снижают показатель успешности. Некритические могут замедлять выполнение или создавать трение, но не отменять факт успеха. Если такого разделения нет, метрика либо становится слишком жесткой, либо перестает быть чувствительной к проблемам.

Также следует заранее учесть возможные обходные пути. Пользователь может прийти к нужному результату способом, который команда не закладывала. В таких случаях важно заранее решить, считается ли такой путь успешным. Иногда это допустимый вариант, иногда сигнал о проблеме в логике интерфейса — критерии успеха должны учитывать эту границу.

Четко заданные критерии позволяют интерпретировать результаты без догадок. Команда понимает, что именно измеряется, почему показатель изменился и какие выводы можно делать дальше. Без этого Task Success Rate превращается в формальную цифру, которая выглядит убедительно, но не делает продукт лучше.

Минимальный набор метрик для управляемых выводов

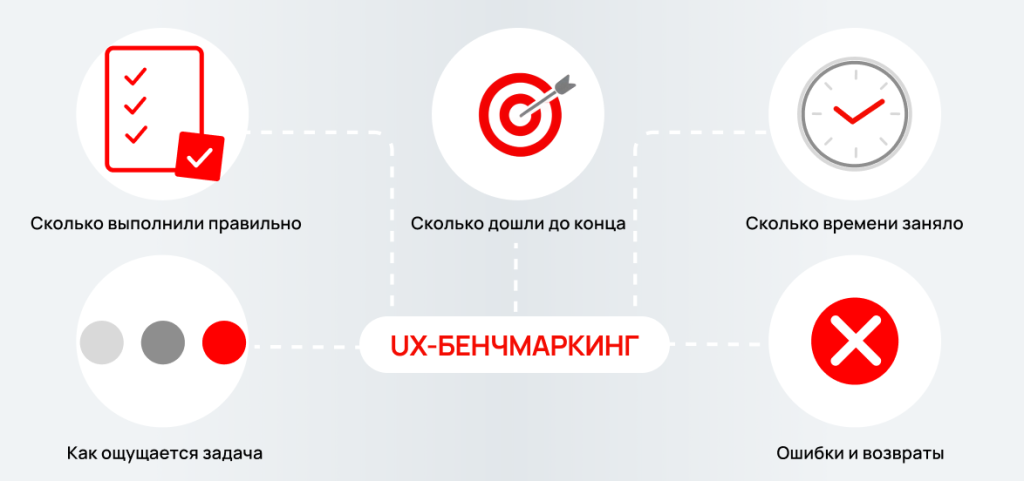

Для корректного бенчмаркинга пользовательского опыта не требуется слишком много показателей. Лучше опираться на небольшой набор метрик, каждый из которых отвечает на конкретный вопрос о состоянии сценария. Помимо уже рассмотренных Task Success Rate и Task Completion, в него стоит включить:

-

Время выполнения задачи (Time on task). Его используют там, где скорость имеет значение для опыта пользователя. Рост времени при стабильной успешности часто сигнализирует о лишних шагах, неочевидных решениях или перегруженных экранах.

-

Ошибки и возвраты (Errors and backtracks). Они показывают, где пользователь теряет ориентацию, вынужден исправлять ввод или возвращаться на предыдущие шаги. Даже при высоком Task Success Rate такие сигналы могут быть признаком скрытого трения в сценарии.

-

Краткая субъективная оценка сложности задачи (Perceived difficulty). Простая шкала помогает понять, как пользователь воспринимает сценарий при формально корректных показателях. Это не основная метрика, а поясняющий слой к цифрам, дополняющий контекст.

Такого набора в большинстве случаев достаточно, чтобы видеть состояние ключевых сценариев, отслеживать изменения во времени и обосновывать продуктовые решения данными. Все остальное имеет смысл добавлять только тогда, когда понятно, какой именно вопрос должна закрыть дополнительная метрика.

Как интерпретировать результаты и использовать их в разработке

Результаты UX-бенчмаркинга ценны только тогда, когда их правильно читают и используют в работе. Сами по себе цифры не дают ответа, что именно нужно менять. Они показывают, где искать причину и в каком направлении двигаться дальше.

Анализ стоит начинать с Task Success Rate по ключевым сценариям. Просадки здесь указывают на проблемы с достижением результата. Это приоритетная зона внимания, даже если доля завершения сценария по Task Completion формально высокая.

Далее уже имеет смысл предметно смотреть на Task Completion. Низкий показатель здесь указывает на то, что сценарий ломается целиком и пользователь не может дойти до результата. В таких случаях работа начинается с базовой логики и структуры взаимодействия, а не с точечных улучшений. Если падение связано с конкретным шагом, это удобно проверять через воронку событий и сразу смотреть записи сессий. Такой режим дают, например, Microsoft Clarity и Hotjar.

После этого оценивают время выполнения задачи и ошибки. Рост времени при стабильной успешности часто говорит о лишних шагах или неочевидных решениях. Ошибки и возвраты помогают локализовать проблемные места внутри сценария и понять, где пользователь теряет ориентацию.

Важно рассматривать показатели в связке, а не по отдельности. Один и тот же сценарий может выглядеть стабильным по одной метрике и проблемным по другой. Совокупность сигналов дает более точную картину и снижает риск неверных выводов.

Интерпретация результатов должна заканчиваться формулировкой гипотез: что именно мешает пользователю, какой элемент создает трение, какое изменение может улучшить ситуацию. После внедрения изменений замер повторяют в тех же условиях. При таком подходе UX-бенчмаркинг превращается из еще одного отчета в рабочий инструмент развития продукта.